Wie funktioniert die neue Lösung?

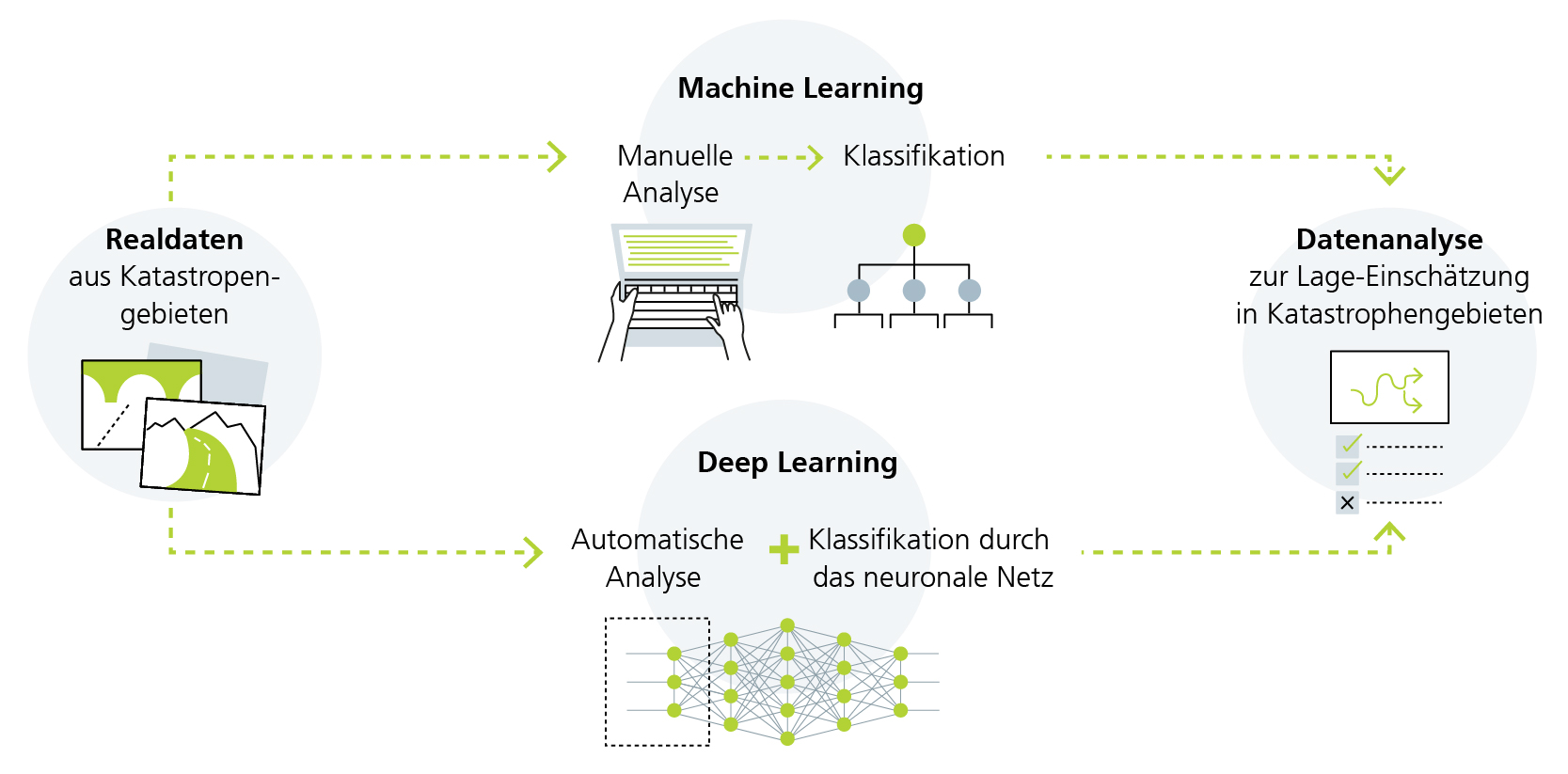

Grundlage für die vollautomatische und schnelle Analyse von Drohnenbildern ist die Kombination von Bildverarbeitungs- und Deep-Learning-Algorithmen, die die Forschenden am Fraunhofer ITWM entwickeln. Deep Learning bezeichnet eine Disziplin des Machine Learning, die für die Auswertung großer Datenmengen künstliche neuronale Netze nutzt. Als Vorbild dienen dafür die biologischen neuronalen Netze wie das menschliche Gehirn.

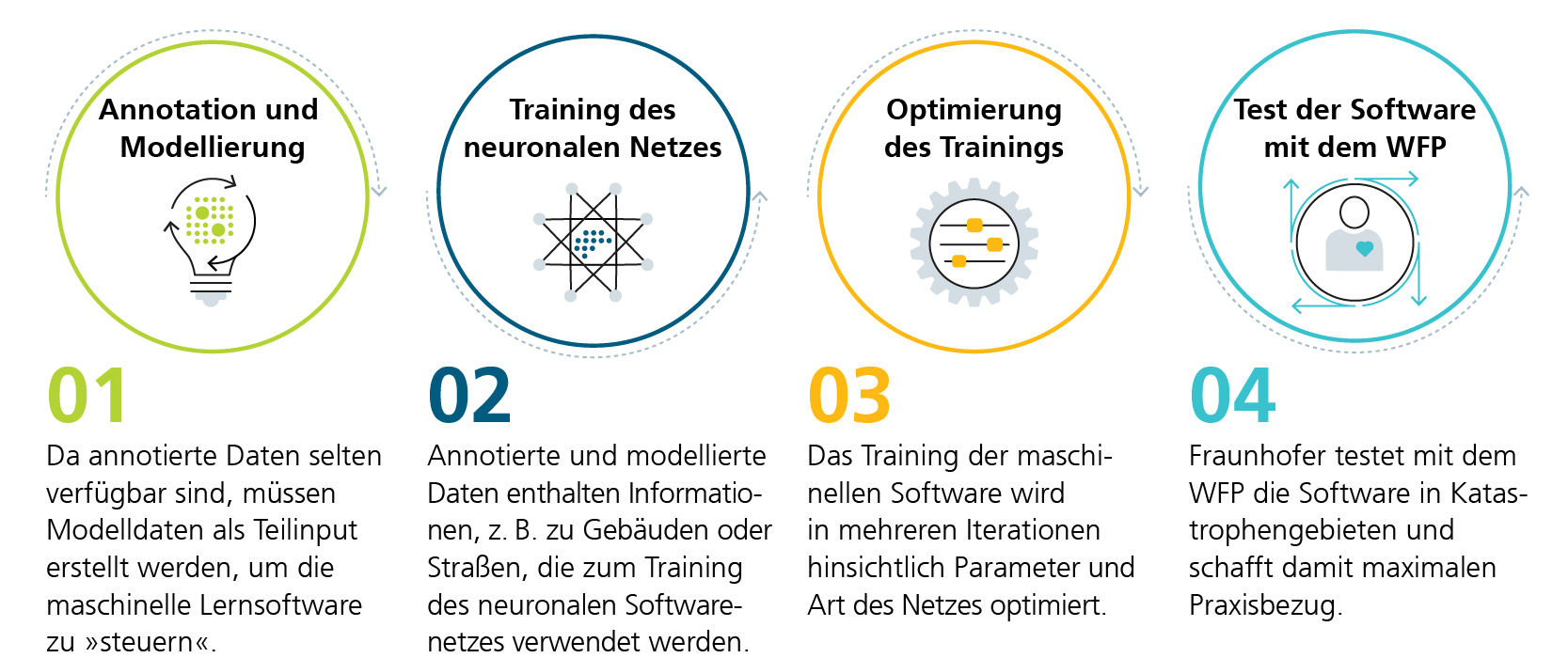

Damit die Künstliche Intelligenz (KI) den selbstständigen Lernprozess aufnimmt, müssen die Forschenden die Software mit Daten »anfüttern«. Dafür verwenden sie Satellitenaufnahmen aus vergangenen Einsätzen des World Food Programme der Vereinten Nationen (WFP), versehen sie mit Informationen zu z. B. Gebäuden oder Straßen. Dieser Prozess wird als »Annotation« und »Modellierung« bezeichnet. Nach diesen Vorarbeiten werden diese Rohdaten in das neuronale Netz der Software eingespeist.

Mit diesen aufbereiteten Daten startet das Training unter Realbedingungen in Krisengebieten. Auf Basis der annotierten Daten und Deep-Learning-Algorithmen beginnt die Software neuaufgenommene Bilddaten selbstständig zu erfassen und zu analysieren. Durch die vielen Schichten (sog. Layer) und das wiederholte Verknüpfen von Inhalten können Daten von Deep-Learning-Systemen selbst erlernt werden. Im Gegensatz zu klassischen Machine-Learning-Verfahren entfällt hierbei das aufwendige und zeitintensive händische Modellieren von Daten. Die Software wird also mit der Zeit immer besser. Die Forschenden begleiten die Software beim Training solange, bis sie gut genug ist, um Katastrophenhelfenden im Ernstfall eine belastbare und wertvolle Hilfe zu sein.